如果您不想让您的网站被搜索引擎爬虫抓取,可以通过robots.txt文件或者.htaccess文件来进行屏蔽,具体操作方法请看下面的教程。

Robots协议(也称为爬虫协议、机器人协议等),全称是“网络爬虫排除标准”(Robots Exclusion Protocol),网站通过robots.txt协议文件告诉搜索引擎哪些页面可以抓取,哪些页面不能抓取。当一个搜索引擎蜘蛛访问一个站点时,它会首先检查该站点根目录下是否存在robots.txt文件,如果存在,搜索机器人就会按照该文件中的内容来确定访问的范围;如果该文件不存在,所有的搜索蜘蛛将能够访问网站上所有没有被口令保护的页面。因此,如果我们不希望搜索引擎抓取网站时,就可以通过robots.txt来屏蔽掉搜索引擎蜘蛛,robots.txt具体的使用方法请参考百度百科词条“robots.txt协议”

每个搜索引擎的爬虫都有自己的User-Agent,通过User-Agent告诉别人自己的身份信息,因此,我们可以用.htaccess文件来屏蔽某个(某些)User-Agent的访问来达到屏蔽某个(某些)搜索引擎爬虫抓取网站。代码如下:

代码示例1:直接告诉爬虫网站服务器出现503错误了

#屏蔽必应和MSN的爬虫并告诉爬虫出现503错误

ErrorDocument 503 "System Undergoing Maintenance"

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} (bingbot|msn) [NC]

RewriteRule .* - [R=503,L]

代码示例2:告诉爬虫网站重定向到新的网址了(让爬虫去抓取新网址上的网站)

#屏蔽百度、谷歌和搜搜的爬虫并告诉爬虫网站重定向到了http://www.wphostz.net

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} (baiduspider|googlebot|soso) [NC]

RewriteRule ^(.*)$ http://www.wphostz.net/ [R=301,L]

上面代码示例1和示例2里面两种代码都可以用,根据您自己的需要选用(如果只是暂时性屏蔽,用示例1的代码;如果网站已经转移到新的网址上了,就用示例2的代码,用示例2的代码要记得将http://www.wphostz.net修改成您网站的新网址),将代码复制到您网站根目录下的.htaccess文件里面就可以了。

上面示例代码里面只列举了几种常见的搜索引擎的User-Agent,如果您想屏蔽更多的搜索引擎,您可以先在网上搜下那些搜索引擎的User-Agent是什么,然后在代码里面RewriteCond %{HTTP_USER_AGENT}那行代码后面括号里面加上您想屏蔽的搜索引擎的User-Agent就可以了。

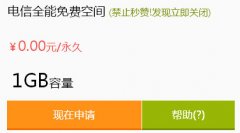

标准互联提供免费1G电信全能空间申请脚本:Asp, ASP.net, php, html, shtmlIIS:500个数据库:赠送100M MYSQL域名:支持绑定3个域名备案:无需备案,任意绑定域名强制广告:必须文字链接流量:

标准互联提供免费1G电信全能空间申请脚本:Asp, ASP.net, php, html, shtmlIIS:500个数据库:赠送100M MYSQL域名:支持绑定3个域名备案:无需备案,任意绑定域名强制广告:必须文字链接流量:

做一个网站,更新太麻烦,特别是大规模的更新,而且工作量也非常大。真不知那些站长,是如何制作网页模板的。隔三岔五将网站来个大更新,不知道他们是怎么忙过来的。 告诉你这

做一个网站,更新太麻烦,特别是大规模的更新,而且工作量也非常大。真不知那些站长,是如何制作网页模板的。隔三岔五将网站来个大更新,不知道他们是怎么忙过来的。 告诉你这

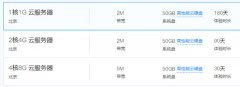

今天免费空间小编给大家推荐腾讯云服务器,腾讯云推出云产品体验,云服务器0元试用。详细信息如下:

今天免费空间小编给大家推荐腾讯云服务器,腾讯云推出云产品体验,云服务器0元试用。详细信息如下:

对于今日头条极速版看新闻就能赚钱,我们大家都是很知道的。那么你知不知道今日头条极速版怎么操作才能赚钱呢?下面免费空间小编给大家分析一下:

对于今日头条极速版看新闻就能赚钱,我们大家都是很知道的。那么你知不知道今日头条极速版怎么操作才能赚钱呢?下面免费空间小编给大家分析一下:

誉岚主机,免费提供香港php+mysql+ftp虚拟主机。可绑域名,赠送三级域名誉岚免费空间_可绑域名,赠送三级域名_php+mysql+ftp虚拟主机-誉岚主机申请地址:https://www.yulanweb.top/免费空间誉岚主

誉岚主机,免费提供香港php+mysql+ftp虚拟主机。可绑域名,赠送三级域名誉岚免费空间_可绑域名,赠送三级域名_php+mysql+ftp虚拟主机-誉岚主机申请地址:https://www.yulanweb.top/免费空间誉岚主